Sin dagli albori dell’intelligenza artificiale, circa sessant’anni fa, i ricercatori hanno misurato i progressi di tale tecnologia stabilendo dei parametri di riferimento, come la capacità di riconoscere immagini, costruire frasi di senso compiuto e prendere parte “come esseri umani” a giochi come gli scacchi. Questi parametri di riferimento si sono dimostrati un modo utile per determinare se l’intelligenza artificiale potesse essere in grado di fare più cose, guidando al contempo i ricercatori verso la creazione di strumenti tecnologici che siano ancora più utili.

Negli ultimi anni, i sistemi di intelligenza artificiale hanno superato molti test creati ad hoc dai ricercatori, battendo gli esseri umani in molti campi. Per gli scienziati, la missione attuale è quella di creare parametri di riferimento che possano “catturare” e – ad esempio – riflettere abilità “sfuggenti” come il ragionamento, la creatività e la capacità di imparare in maniera autonoma. Per non parlare di aree come l’intelligenza emotiva, che sono abbastanza difficili da misurare negli esseri umani. Ad esempio, un sistema di intelligenza artificiale può funzionare così bene da non permettere agli esseri umani di dire se un’immagine o un testo sono stati creati dall’uomo o da una macchina.

L’intelligenza artificiale, ad esempio, non avrebbe problemi nel rispondere alla domanda: “chi ha vinto l’Oscar per la migliore attrice l’anno scorso?”. Ma se le chiedessimo “perché” l’attrice ha vinto, l’intelligenza artificiale rimarrebbe “perplessa”. In pratica, mancherebbe il ragionamento, la contestualizzazione nonché la comprensione emotiva che sono necessari per rispondere adeguatamente ad una “semplice” domanda come quella.

Dal test di Turing alla disfatta di Kasparov

Tornando indietro nel tempo è possibile comprendere quanto l’intelligenza artificiale sia arrivata lontano, e quanta strada dovrà ancora fare guardando alle sfide che sono dinanzi a lei. Il primo punto di riferimento (o “benchmark”) ce lo diede il grande genio inglese Alan Turing. Nel 1950, propose di considerare la domanda: “Le macchine possono pensare?”. Per determinarlo, descrisse un esperimento – poi soprannominato il test di Turing – in cui un giudice umano ascolta una conversazione tra una persona e una macchina progettata per generare risposte simili a quelle umane. Se il giudice non riesce a identificare correttamente quale tra i due “conversanti” è l’uomo, la macchina supera quello che Turing chiamava “Imitation Game” (Gioco dell’Imitazione). Cercare di superare il Test di Turing era uno dei primi obiettivi dell’intelligenza artificiale dell’epoca. E così fu fino agli anni novanta, quando i ricercatori iniziarono a “spostare” i parametri di riferimento dall’uguagliare l’intelligenza umana a batterla su compiti specifici. Non si sarebbe più puntato all’eguaglianza tra le intelligenze, ma al superamento dell’intelligenza umana da parte della macchina. E uno dei primi progressi si raggiunse nel 1997, quando il programma IBM Deep Blue batté il campione russo di scacchi Garry Kasparov. Avvenimento che fu visto come un balzo in avanti nello sviluppo dell’intelligenza artificiale.

La primavera dell’intelligenza artificiale

Ma il vero balzo in avanti, che prende il nome di “primavera dell’intelligenza artificiale”, si ebbe a partire dal 2012. Quello fu l’anno in cui l’ImageNet Challenge – un test per vedere se un algoritmo poteva rilevare e identificare correttamente ciò che veniva mostrato nelle foto contenute in un database di 14 milioni di immagini – segnò una svolta nel settore in esame. AlexNet, un tipo di algoritmo di Intelligenza artificiale (rete neurale), ottenne un tasso di errore del 15.3%. Dopo che la maggior parte dei concorrenti ebbe tassi di errore inferiori al 5% nel 2017, i ricercatori dichiararono che avrebbero lavorato su una nuova versione del programma. Negli ultimi anni invece (dal 2018), i sistemi in grado di comprendere il linguaggio naturale, così come quelli che possono decifrare accuratamente immagini e video digitali, hanno sfondato una successione di parametri di riferimento. Ad esempio, nel 2018 venne rilasciato un parametro di riferimento chiamato GLUE (General Language Understanding Evaluation), che richiedeva ai sistemi di intelligenza artificiale di superare test come riconoscere se le frasi si parafrasassero a vicenda, determinando se una recensione di un film fosse positiva, negativa o neutrale.

Molti di questi compiti furono battuti così rapidamente che i ricercatori elevarono tale parametro di riferimento al “rango” di “SuperGLUE” verso la fine del 2019. A gennaio 2021 invece, i ricercatori che lavoravano per creare sistemi in grado di battere il parametro di riferimento SuperGLUE avevano già superato quello che la maggior parte degli esseri umani è in grado di fare. Queste tempistiche sempre più veloci nel battere i parametri di riferimento hanno indotto i ricercatori a chiedere di strutturare tali parametri in un modo che possano tenere il passo con il ritmo dell’innovazione nel campo dell’intelligenza artificiale.

Tutti i limiti del (buon) regolamento UE su intelligenza artificiale

L’Alexa Prize di Amazon, che sfida gli studenti universitari a creare chatbot che possano parlare naturalmente di vari argomenti per venti minuti e ottenere un punteggio da una giuria umana di almeno 4 su 5, è uno dei diversi tentativi dell’azienda di Jeff Bezos di scalare un parametro di riferimento e farlo durare più a lungo, testando al contempo più abilità nel medesimo lasso di tempo. L’Alexa Prize si è tenuto tre volte (la quarta è in corso) senza che nessuna squadra abbia raggiunto il tempo o il punteggio necessari (entrambi) per vincere. A marzo 2021 l’azienda di Bellevue ha annunciato l’avvio di un nuovo test chiamato “TaskBot Challenge”, la prima sfida di Intelligenza artificiale “conversazionale” su voce e immagini. Il test punterà a vedere quanto può spingersi un’intelligenza artificiale con l’analisi di voce e immagini per far ottenere ai clienti le informazioni che vogliono, a partire da compiti “di cucina” e al miglioramento della vita domestica. Dopo la fine della conversazione, agli utenti verrà chiesto di giudicare l’utilità del TaskBot su una scala da 1 a 5, oltre a fornire un feedback volontario.

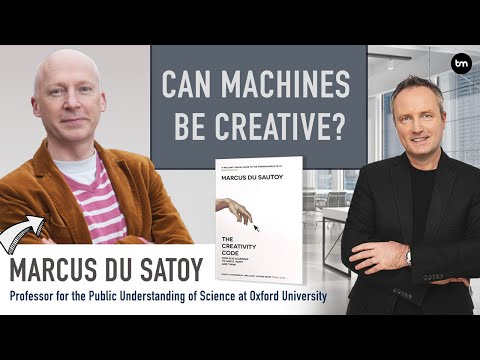

Creatività e test Lovelace

La creatività è un’altra area per la quale i ricercatori stanno lottando per sviluppare parametri di riferimento. E, infatti, non vi è alcun dubbio che l’intelligenza artificiale e la creatività siano inestricabilmente legate tra loro. Nel 2014 il “Lovelace 2.0 Test of Artificial Creativity and Intelligence” (una sorta di “Test di Turing alternativo”) esordì come modalità per misurare la creatività nell’intelligenza artificiale. Nel test si propose di avere un giudice umano che desse all’intelligenza artificiale un compito creativo, come creare una poesia o dipingere un quadro basato su una richiesta specifica. Se il giudice umano avesse trovato un’intelligenza artificiale in grado di eseguire la richiesta, così come qualsiasi altro parametro aggiunto in corso d’opera dal giudice, l’intelligenza artificiale avrebbe passato il test. Il giudice avrebbe potuto anche aggiungere requisiti più difficili, come passare da una poesia di cinque righe a qualcosa di più lungo, in turni successivi.

Come il test di Turing, Lovelace era più un esperimento di pensiero che un test vero e proprio. Quando uscì per la prima volta, non si pensava potesse esistere un’intelligenza artificiale in grado di superare anche un solo round. Ma nel giro di un paio d’anni, cominciarono ad uscire casi che documentavano sistemi in grado di creare un’immagine sulla base di un testo. All’inizio del 2021, DALL-E by OpenAI, poteva fare illustrazioni stravaganti sulla base di alcune frasi scelte dagli utenti (disegno di un ravanello che porta a spasso un cane). In pratica, DALL-E sovvertì le previsioni sull’impossibilità di passare il Test Lovelace formulate appena sei anni prima.

Precisione vs. distorsione

Man mano che i sistemi di intelligenza artificiale odierni diventano più efficienti e sofisticati serve spingere verso la necessità di modificare alcuni parametri di riferimento. Per esempio, i sistemi di riconoscimento facciale sono sorprendentemente efficaci; tuttavia, ad esempio, non possono sempre riconoscere con certezza le donne di colore, anche perché i sistemi di Intelligenza artificiale sono (spesso) addestrati su training data tarati su foto di uomini di etnia indoeuropea. Siamo in presenza del cosiddetto “bias” (o pregiudizio) dell’intelligenza artificiale. I ricercatori stanno cercando di creare dataset equilibrati per sopperire a quei parametri di riferimento che raramente considerano il razzismo o il sessismo (nonché la protezione dei dati) nel settaggio dell’intelligenza artificiale.[1]

- Why We Need New Benchmarks for AI. The Wall Street Journal ↑