Allineare l’intelligenza artificiale alle norme etiche e ai valori umani è un processo complesso, ma vitale. L’AI Alignment, o allineamento dell’IA, rappresenta una sfida cruciale per il futuro della tecnologia e della società, in particolare per le grandi potenze tecnologiche come Stati Uniti e Cina.

l’analisi

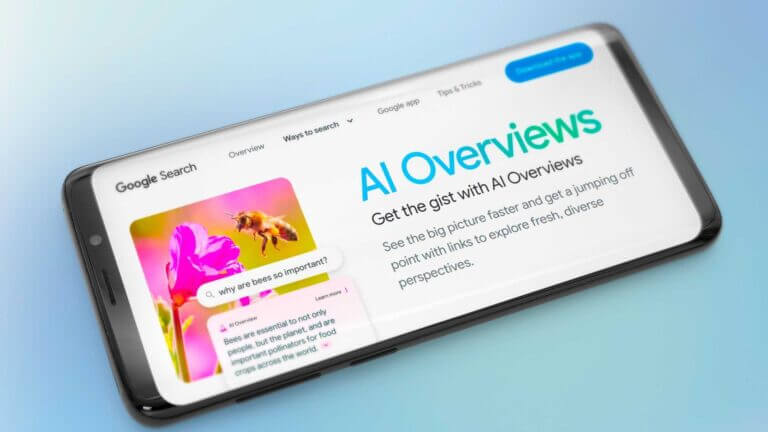

AI alignment: l’intelligenza artificiale potrà mai rispettare i valori umani?

L’allineamento dell’Intelligenza Artificiale è cruciale per garantire sicurezza, controllo e rispetto dei valori umani. Questo processo continuo e soggettivo mira a rendere i modelli di AI utili, affidabili e privi di pregiudizi, affrontando le sfide etiche e culturali globali per un futuro tecnologico sicuro e inclusivo

Legal & Data Protection Specialist at Fondazione IRCCS Casa Sollievo della Sofferenza

Continua a leggere questo articolo

Argomenti

Canali

EU Stories - La coesione innova l'Italia