Sempre più spesso capita di ascoltare confronti a volte improbabili sul funzionamento delle intelligenze artificiali generative che usiamo, ormai, quotidianamente. È normale quindi chiedersi: come possiamo confrontare due modelli di intelligenza artificiale generativa?

Indice degli argomenti

Orientarsi nei meandri dei sistemi di IA generativa

Nella giungla di sistemi è sempre più difficile capire la relazione tra i modelli AI veri e propri rispetto a numerose applicazioni che le usano con declinazioni sempre più difficili da seguire. Ho letto, ad esempio, un articolo che riportava prompt che generano belle immagini utilizzando MidJourney e mi sono chiesto quale sarebbe stato il risultato se avessi usato lo stesso prompt con il modello DALL-E usato da Bing image creator.

Ecco un esempio di questi prompt e il confronto tra MidJourney (sopra) e DALL-E 2 (sotto):

A close-up shot of a raindrop about to fall from a leaf, with a focus on reflection and the vibrant greenery around it, creating a fresh and pure atmosphere.

Sebbene l’apprezzamento di un’immagine sia largamente soggettivo le ultime versioni di MidJourney sembrano generare immagini più fotorealistiche di quanto siano le analoghe generate da DALL-E 2.

La lunga storia dei benchmark

Il bisogno di misurare in un modo oggettivo le prestazioni di un computer è un bisogno vecchio quasi quanto i computer, ma è l’oggetto del confronto a rendere complessa la preparazione di un programma di benchmark che, eseguito su due sistemi, produca un valore che dica che uno dei è migliore dell’altro in uno specifico ambito.

Se l’oggetto della misura è la velocità di completamento di un calcolo la misura è abbastanza oggettiva, anche se spesso ci si lamenta che i calcoli usati non sono sempre rappresentativi dei programmi in uso. Le polemiche sono decisamente più facili da alimentare quando si analizzano parametri meno facili da misurare come, ad esempio, le prestazioni di un personal computer: in questo caso è necessario misurare parametri come l’interattività, aspetto decisamente più difficile da catturare in modo oggettivo, un sistema operativo infatti alloca le risorse in base alla storia delle richieste e quindi a parità di esecuzione lo stesso sistema può risultare un po’ più o meno performante.

La rappresentatività del benchmark è spesso oggetto di polemiche, si tratta dell’angolo di attacco più facile da prendere: “il mio sistema performa meglio di così con applicativi reali, il benchmark è sintetico e scarsamente rappresentativo!”.

Quali benchmark usare per misurare e confrontare le IA generative

Ma quali benchmark possiamo usare per misurare e confrontare le intelligenze artificiali generative? Ad oggi non vi sono metodologie diffuse di confronto, anche a causa della giovinezza di questi sistemi, ma si cominciano già ad osservare i primi test di confronto dei modelli LLM per la generazione di testo.

Il sito Hugginface dove vengono pubblicati modelli AI ha una leaderboard dove i modelli vengono confrontati su 4 benchmark per chatbot. I requisiti prevedono che il modello sia disponibile sulla piattaforma e quindi non troviamo nella lista né GPT4 di OpenAI né Google Bard.

In questo caso si tratta di benchmark sviluppati in modo tradizionale ed usati per misurare le prestazioni dei modelli, ma recentemente GPT4 è stato oggetto di notizia per aver mostrato ottime performance nel sostenere test per esseri umani e non semplici benchmark sintetici (ha mostrato un incredibile risultato ai test MIT ad esempio con un incredibile 90%). Anche senza considerare il test di Turing è abbastanza naturale usare gli uomini come metro di paragone di un’intelligenza artificiale abbastanza senziente. Ma i test sono test di conoscenza, più raramente di ragionamento, ed una macchina è più brava di un essere umano a ricordare.

Resta il fatto che ad oggi le metriche per misurare le intelligenze artificiali generative non sono pienamente soddisfacenti e spesso sono ingannevoli poiché nascondono numerosi aspetti di questi modelli così complessi, generando spesso aspettative che vengono deluse.

Un confronto tra “umani”

Nel mentre aspettiamo benchmark capaci di confrontare modelli differenti in modo più qualitativo dobbiamo accontentarci dell’interazione con il modello ed una valutazione empirica delle sue prestazioni. Vi sono poi dei requisiti che riducono in modo significativo il numero di modelli disponibili: per esempio i modelli di OpenAI ad oggi sono praticamente gli unici a supportare la lingua italiana (ed un numero significativi di altre lingue). È facile quindi che per ora la scelta nella nostra nazione sia quasi obbligatoria, e la prima prova da effettuare quando troviamo un nuovo sistema è proprio quella di interagire nella nostra lingua.

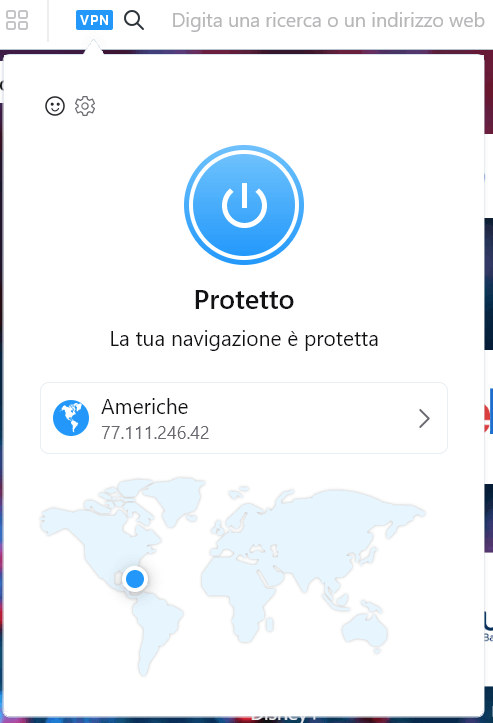

Usando la funzione VPN del browser Opera è possibile accedere a Google Bard con il proprio account Google, per scoprire che l’interazione in italiano al momento non è possibile.

In questo momento il sistema supporta solo tre lingue, un numero sicuramente poco soddisfacente per una big tech come Google:

E non si tratta di una limitazione da poco visto che Google Docs introdurrà questa tecnologia lasciando fuori la nostra nazione dai suoi benefici e all’uso di Copilot in Office 365 basato su ChatGPT-4 di OpenAI.

Sembra quindi poco utile in questo contesto soffermarsi sui benchmark a meno che non si faccia ricerca o si sviluppino modelli da addestrare.

Ma è sempre necessaria tutta questa intelligenza?

In Toscana usa dire “nel più ci sta il meno”, è evidente che se si usa un modello di AI più “intelligente” sarà più facile e flessibile da inserire nei propri sistemi o flussi di lavoro, ma a volte modelli più piccoli possono mostrare performance decisamente accettabili su uno specifico compito e portare a risparmi, o ad impieghi altrimenti impossibili.

L’esecuzione di un modello è possibile anche sul proprio computer, io ad esempio ho generato un’immagine che può essere letta con un’applicazione che legge codici QR usando un modello di stable diffusion seguendo le opportune istruzioni.

Sono disponibili istruzioni analoghe per poter eseguire modelli come LLaMa, capaci comunque di prestazioni più che decenti e spesso sufficienti per svolgere compiti senza dover richiedere accesso alla rete o dover affrontare problemi di privacy nell’uso di servizi cloud esterni.

Conclusioni

Ad oggi GPT-4 è sicuramente il modello da battere (anche se dai primi leak sembra che non sia un modello ma piuttosto un sistema cooperativo di diversi modelli di AI), ma se abbiamo necessità di supportare molte lingue, e in particolare l’Italiano, allora i modelli di OpenAI sembrano quasi obbligatori per chi vuole avvalersi di queste tecnologie, sia usati direttamente che indirettamente (come ad esempio su https://you.com oppure bing.com accedendo con Microsoft Edge).

Al momento sembra difficile che emergano benchmark capaci di effettuare un confronto generale delle performance di questi modelli di intelligenza artificiale. Almeno per ora sembra che il compito di valutarne l’intelligenza o la stupidità sembra che spetti a noi (e non è necessariamente una buona nuova visto che gli LLM ci raggirano abbastanza facilmente come mostrano alcune ricerche sulla disinformazione).