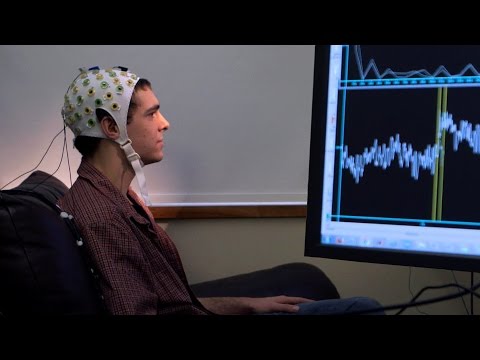

Le interfacce neurali, conosciute anche come interfacce “cervello-macchina” o “cervello-computer”, sono un mezzo di comunicazione che “lega” il cervello dell’uomo ad un determinato dispositivo “artificiale”. Tali interfacce hanno già aiutato alcuni ricercatori nel controllo delle crisi epilettiche e nella riduzione dei tremori nei pazienti affetti dal morbo di Parkinson. Una soluzione che, nel prossimo futuro, affronterà applicazioni ancora più complesse, come il ripristino del linguaggio e la regolazione dell’umore nei pazienti interessati.

Indice degli argomenti

L’obiettivo dell’impiego di interfacce neurali

Su questo fronte è in prima linea lo statunitense UCSF Weill Institute for Neurosciences della University of California di San Francisco. Nel luglio dell’anno scorso tale istituto californiano ha condotto uno studio innovativo, finanziato in parte dal colosso social Meta, che ha tradotto in parole visibili su uno schermo i segnali cerebrali di un uomo affetto da paralisi. La quantità di ricerche effettuate in materia di interfacce neurali è cresciuta costantemente negli ultimi anni. Ad alimentare questa attività sono la disponibilità di computer più potenti, i miglioramenti nell’intelligenza artificiale e l’ulteriore “miniaturizzazione” dei dispositivi che possono essere impiantati nel cervello. Infine, non meno importanti sono i nuovi investitori (del calibro di Elon Musk) che si sono “affacciati sulla piazza”, interessati allo sviluppo ed alla produttività della tecnologia in esame.

L’obiettivo dell’impiego di interfacce neurali è di decifrare l’attività cerebrale umana, alla base di comportamenti “complessi” come il linguaggio e le emozioni, nel tentativo di sviluppare terapie che possano aiutare persone che non riescono a parlare o che soffrono di condizioni neuropsichiatriche come depressione e ansia.

Rischi e sfide delle interfacce neurali

E tutto ciò, ovviamente, non è esente da rischi, in quanto vi può essere, ad esempio, una potenziale “erosione” della privacy (intesa proprio come “diritto ad essere lasciato solo” e, quindi, a godere dell’intima sfera privata), dato che le interfacce neurali danno accesso “diretto” al cervello e ai processi che sono alla base dei pensieri dell’uomo. Il linguaggio, peraltro e di per sé, è davvero “speciale”; inoltre, è sempre molto stimolante cercare di capire come il cervello umano elabora un comportamento così unico. Una delle sfide più grandi è cercare di tradurre quegli impulsi elettrici che il cervello “produce” in continuazione in parole. Il cervello utilizza tali impulsi come “linguaggio proprio” per comunicare con l’esterno. Questo linguaggio ha una sua logica, un suo codice. La vera sfida è capire come funziona questo codice. I segnali che interpretiamo non assomigliano affatto a ciò che si cerca di decodificare, come le parole. Gran parte del lavoro portato avanti dallo UCSF Weill Institute sfrutta i progressi delle scienze informatiche nell’ambito dell’intelligenza artificiale e dell’apprendimento automatico (conosciuto anche come Machine Learning).

Un’IA a “immagine e somiglianza” del nostro cervello? La sfida è possibile

Progressi e scenari

Si pensi, poi, che negli ultimi cinque anni il progresso che è stato portato avanti per andare oltre i singoli suoni ed i singoli impulsi, cercando di decodificarli, è stato impressionante. E siamo ancora agli inizi. Il primo progetto dello UCSF Weill Institute, pubblicato l’anno scorso, si concentrava su un vocabolario di cinquanta parole. E gli obiettivi dell’Istituto di San Francisco puntano ad espandere tale vocabolario, con il continuo tentativo di far “apparire sullo schermo” (e ascoltare) le parole ivi contenute. L’obiettivo primario si concentra sul fatto che una persona paralizzata non pensi semplicemente a una parola e la faccia apparire su uno schermo, ma che sintetizzi effettivamente quei suoni (in pratica, che ritorni a parlare in maniera quasi naturale). E questa risulta essere una sfida molto difficile e ambiziosa, a causa della complessità di produrre parole in modo udibile partendo da un vocabolario molto ampio. Attualmente però, per un numero ridotto di parole, la cosa è più fattibile (e questo ci fa ben sperare).

Un’altra area che entusiasma molto i ricercatori non è solo l’ascolto delle parole pronunciate da un paziente impossibilitato, altrimenti, a farlo, ma anche il controllo di un avatar del viso che non solo parla, ma fa anche i movimenti che normalmente si vedono quando si parla con qualcuno di persona (faccia a faccia). Si pensi sempre al paziente affetto da paralisi che possa non solo tornare a parlare, ma anche a “proiettare” la sua immagine sullo schermo atta a parlare ed interagire in maniera del tutto naturale. Cosa importante in quanto potrebbe accelerare enormemente il processo di apprendimento di una persona affetta da paralisi (si può persino azzardare una connessione con il Metaverso…). La sintesi vocale non è solo “un’insieme di parole”, bensì anche tutte quelle sfumature della voce, come l’intonazione e il ritmo, che (ri)danno dignità ad una persona. Ad esempio, la frase “Sally è andata al negozio” può passare dall’essere un’affermazione ad una domanda cambiando semplicemente intonazione. Le parole sono le stesse, ma il significato cambia. Ecco perché bisogna insistere su questo aspetto.

Ma vi è di più. Si pensi alle diverse lingue. Una parte di ciò che lo UCSF Weill Institute sta cercando di sviluppare è una tecnologia che permetta al paziente di passare dal parlare una lingua ad un’altra. Quando una persona bilingue o poliglotta passa da una lingua all’altra, la macchina deve poterlo rilevare e consentire al paziente di comunicare in più lingue. Ovviamente la questione è, di partenza, complessa. Ad esempio, non vi è una parte del cervello che “pensa” in spagnolo ed un’altra parte che elabora le informazioni in inglese. Per le persone bilingui o poliglotte le informazioni provengono sempre dalla stessa area. E far sì che una macchina capisca questo aspetto è ancora complicato. Ma il dado è tratto…

Per quanto attiene, infine, il fronte della salute mentale, sarebbe interessante comprendere cosa succede quando una persona elabora normalmente le emozioni e come appaiono i segnali del cervello nelle persone che soffrono di depressione (e che, quindi, non hanno una normale regolazione del proprio umore). La speranza è che, comprendendo questi schemi di impulsi elettrici, si possano usare questi ultimi come biomarcatori, ossia come modi per comprendere quando e quali parti del cervello sono coinvolte quando qualcuno manifesta episodi depressivi. Inoltre, cosa molto più importante, si punta ad usare queste informazioni per intervenire e regolare alcune di queste aree in modo che tali episodi possano essere affrontati prima che si manifestino e/o si intensifichino. Nel prossimo decennio, probabilmente, vi saranno molte più terapie mediche basate su dispositivi medici, con la possibilità di essere in grado di interagire con il cervello e di integrare le registrazioni neurali provenienti dalle sue diverse parti.

Conclusioni

Ovviamente, sull’applicabilità delle interfacce neurali bisogna sempre pensare ai rischi presenti e futuri. Si tratta pur sempre di un’operazione al cervello. Inoltre, siamo ancora agli albori di tale tecnologia. Per di più bisognerà fare i conti con profili di natura etica e con le stringenti normative in materia di Intelligenza Artificiale ed in materia di protezione dei dati personali (si pensi al GDPR). Ma siamo sulla buona strada. [1]

- How Brain-Computer Interfaces Could Restore Speech and Help Fight Depression. The Wall Street Journal. https://www.wsj.com/articles/how-brain-computer-interfaces-could-restore-speech-and-help-fight-depression-11662129229 ↑