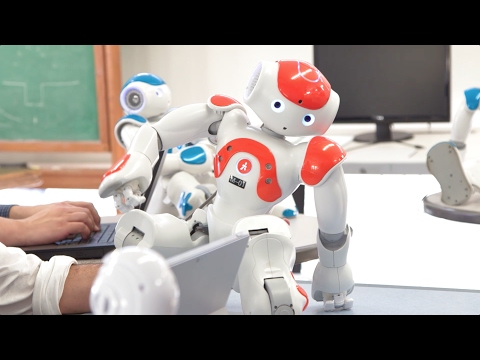

Buona parte di coloro che si occupano di robot sociali, quantomeno in filosofia, ammette la necessità che i robot siano simili a noi – non necessariamente nell’aspetto, beninteso, dal momento che esistono robot sociali e altamente sviluppati che non sono minimamente umanoidi, ma piuttosto nelle modalità di comportamento. E questo anche con l’intento di facilitare l’interazione, dal momento che siamo più disposti, così gli psicologi, a interagire con il noto che non con l’ignoto; in ciò si riflettono anche le volontà di chi progetta e di chi ha interesse a vendere questi robot.

Ma in cosa consiste o dovrebbe consistere questa somiglianza?

Indice degli argomenti

Cosa c’è di sociale in un robot sociale

Per rispondere, la prima domanda sembra dover essere: cosa c’è di sociale in un robot sociale? Se, infatti, la definizione di robot sembra necessariamente un “moving target” (Dautenhahn 2014), ovvero qualcosa che cambia costantemente a seguito delle innovazioni prodotte, la definizione di socialità sembra quantomeno più stabile. Ma se vogliamo evitare di fare lunghe riflessioni sul significato espresso dalla parola “socialità”, iniziamo a chiederci più semplicemente cosa voglia dire per noi essere socievoli. Stringerci la mano? Qualcosa che Asimo, robot della Honda sa fare, sebbene si sia rifiutato di stringerla ad Angela Merkel nel 2015. Più genericamente interagire con degli sconosciuti? Sembra troppo poco per distinguere il nostro agire sociale. Essere capaci di immedesimarci negli altri?

Sembra già qualcosa di più complesso, ma al contempo significativo, dal momento che implica tutta una serie di capacità cognitive oltre che emotive che sembrano dipendere dal possesso di un corpo. Eppure, i robot sociali (o quantomeno alcuni) sembrano possedere la cosiddetta teoria della mente (Devin & Alami 2016), laddove con questa espressione si intende la capacità, già dei bambini piccoli, di immedesimarsi nell’altro e, quindi, di avere rappresentazioni mentali sociali (Frye & Moore 1991). Infatti, se sottoposti al famoso esperimento noto come “Sally-Anne test” o anche “test della falsa credenza”, alcuni robot sociali lo superano dimostrando uno sviluppo delle capacità cognitive che un bambino umano possiede dai tre anni e mezzo in poi, circa. Brevemente, il test chiede a un osservatore onnisciente, perché a conoscenza di tutto ciò che accade nel set sperimentale, di immedesimarsi in uno dei due personaggi che possiede invece solo dati parziali e quindi propriamente richiede la capacità, che i bambini molto piccoli appunto non hanno, di attribuire a un altro ciò che quest’altro sa o non sa.

A questo proposito però un passaggio preliminare, che non si può non citare, è la nota espressione utilizzata da Daniel Dennett (1987), che ha parlato di “posizione intenzionale” (intentional stance), intendendo con questo la capacità di comprendere che le azioni degli altri sono dirette verso un obiettivo (o che viceversa erano inintenzionali) e che derivano da particolari credenze o desideri. Molto noto è il dibattito (che non intendiamo qui approfondire) tra lo stesso Dennett e John Searle sull’intenzionalità che ha portato i due autori a discutere proprio di intelligenza artificiale. Dennett, dal suo punto di vista funzionalista (e accusato di comportamentismo da Searle) sosteneva che se un corpo si comporta in modo intelligente, allora è intelligente.

Robofilosofia: come filosofia e ingegneria dialogano per la robotica sociale

Un robot può davvero credere, desiderare o intendere qualcosa?

La domanda allora è: si può davvero e onestamente parlare di capacità cognitive? Molto dipende da come definiamo i singoli concetti che ci permettono di attribuirle a coloro con cui interagiamo. Ed è proprio qui che entrano in gioco non solo gli esperti di robotica e non solo gli psicologi cognitivi, ma anche i filosofi. Infatti, un modello classico per interpretare le capacità agentive – e quindi cognitive – delle intelligenze artificiali è il cosiddetto modello BDI (Belief-Desire-Intention). Non tutti, naturalmente, sono d’accordo sulla possibilità di attribuire queste tre capacità a un robot: un robot può davvero credere, desiderare o intendere qualcosa? Molto dipende proprio da come definiamo questa triade. Anche in un’ottica che non intenda sposare il funzionalismo, ovvero ridurre la mente alle sue funzioni, restano possibili più opzioni.

Così, da un lato, vediamo filosofi che negano apertamente questa possibilità: i robot possono fingere di averle, ovvero simulare, ma non avere davvero intenzioni, credenze o desideri (questa, per esempio, la posizione del filosofo Seumas Miller). Dall’altra parte, coloro che sostengono la necessità di utilizzare il modello BDI perlopiù esprimono la propria consapevolezza che esista una differenza sostanziale tra, poniamo, possedere un’intenzione per un essere umano e un robot: non si vuole affermare che i due sono identici, quanto piuttosto che utilizzare lo stesso concetto è utile perché si tratta di concetti che ci servono anche a descrivere il nostro modo di comprendere le azioni altrui. I robot, dunque, avranno intenzioni che verranno attribuite loro sempre e solo dagli umani (dagli umani che li hanno progettati prima e da chi li utilizzerà, poi), ma parlare ciononostante di intenzioni ci permette di interagire in un modo più semplice, perché umano o quantomeno antropomorfizzato, con quegli stessi robot.

Questi, infatti, sono pensati soprattutto per aiutarci, per esempio per guidarci nei grandi aeroporti, come Spencer, o nei grandi centri commerciali: dovremmo perciò essere capaci di attribuire loro la volontà di aiutarci e, di conseguenza, dovremmo essere capaci di comprendere il comportamento del robot o di ottenere una adeguata e trasparente risposta nel caso in cui invece il loro comportamento ci risultasse incomprensibile (da qui il grande dibattito sulla necessità di trasparenza).

Conclusioni

In conclusione, si possono disegnare robot capaci di comprendere che le azioni degli umani che ne fanno uso sono intenzionali? Possiamo applicare la posizione intenzionale ai robot per comprenderli? La risposta alla prima domanda sembra affermativa se, nuovamente, facciamo appello alla teoria della mente e alla possibilità di implementarla quantomeno in alcuni robot. Quanto alla seconda domanda, ritorna la duplicità dei filosofi nei confronti dei robot come esseri senzienti: o si tratta di una metafora pericolosa perché fuorviante e allora va abbandonata o, al contrario, è uno strumento utile perché come esseri umani siamo capaci di giudicare solo ciò che ci assomiglia. Una risposta definitiva, però, sembra impossibile da fornire.

Bibliografia

Dautenhahn, K. (2014). Human-Robot Interaction. In M. Soegaard & R. F. Dam (Eds.), The encyclopedia of human-computer interaction (2nd ed.). Aarhus/Denmark: The Interaction Design Foundation. (Disponibile online: https://www.interaction-design.org/encyclopedia/human-robotinteraction.html).

Dennett, D.C. (1987/1996). The Intentional Stance (6th printing), Cambridge, Massachusetts: The MIT Press, (First published 1987).

Devin, S. & Alami, R. (2016). IEEE International Conference on. IEEE, 2016, An implemented theory of mind to improve human-robot shared plans execution Human-Robot Interaction (HRI), 2016 11th ACM

Frye, D. & Moore, C. (1991). Children’s theories of mind: Mental states and social understanding. Lawrence Erlbaum Associates, Inc.