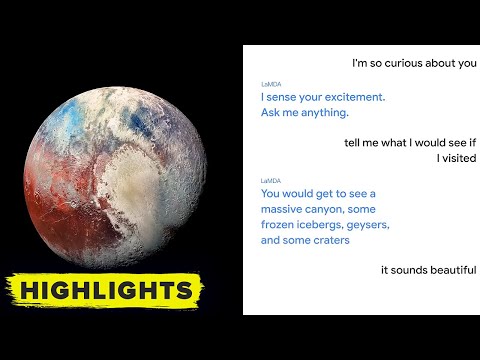

La chatbot di Google, LaMDA, è un sistema capace di partecipare dinamicamente ai dialoghi senza seguire due volte lo stesso percorso. Fu addestrato su tera-byte di dati provenienti da social media, Wikipedia, libri, hosting come GitHub e altre fonti sul Web. Il risultato è di certo interessante, ma sono molte le criticità che solleva.

Il sistema non è ancora eccellente, anzi, spesso un terzo delle risposte che dà è errata e a volte promette di rispondere, per poi lasciare cadere la conversazione, ciononostante non è questo il limite maggiore. Infatti, tale aspetto potrebbe essere sempre migliorabile. Il problema, al contrario, è collocato alle fondamenta del progetto, mi riferisco all’obiettivo di volerlo applicare alle ricerche sul web, sostituendo i vecchi browser.

Linguaggio naturale e intelligenza artificiale: a che punto siamo

In questo caso il “Che cos’è” socratico con cui quotidianamente interroghiamo Google non verrebbe risolto con una lista di siti nei quali probabilmente troveremo ciò che ci interessava sapere. Al contrario l’indagine verrebbe svolta con una serie di domande e risposte, seguendo turni conversazionali con il bot, attraverso quello che sembrerebbe un metodo più vicino alla dialettica di Socrate. Insomma, di primo acchito questa sembrerebbe una rivoluzione meravigliosa: al sapere manualistico parrebbe farsi strada una modalità di apprendimento dinamica, viva, come a concretizzare il sogno platonico. Di certo è interessante la sua capacità di riuscire a personificare oggetti, monti, personaggi storici, in quella che potrebbe sembrare una metodologia espositiva più vicina agli umani, sensibili alla concretezza, ai racconti e refrattari al sapere meccanico o astratto delle formule. In realtà come al solito non è tutto oro ciò che luccica. I limiti maggiori di impiegare un assistente vocale al posto della classica ricerca tramite browser sono la passività a cui saremmo costretti e l’errore di poter scambiare una IA per un vero educatore, con tutto ciò che questo equivoco comporterebbe.

Indice degli argomenti

Il web non è un maestro

Il problema dietro questo approccio è immediatamente chiaro: l’Intelligenza Artificiale non è Socrate. Il fine di internet non è quello di fingere di essere un maestro o un facilitatore umano che, attraverso una serie di domande e di risposte, conducesse l’alunno a conoscere, a fare, a essere. Internet è un ambiente e l’ambiente non è un maestro; è uno spazio in cui l’educazione può avere luogo. L’aula scolastica, il museo, il web, il bosco sono tutti contesti nei quali gli organismi cercano di rispondere alle proprie esigenze rintracciando le informazioni rilevanti. Il browser, in questo, è solo uno strumento, un’interfaccia con cui accedere ai luoghi e alle informazioni usabili in differenti maniere all’interno della propria azione. La relazione che il browser rende possibile può rivelarsi proficua come no a seconda che i soggetti trovino le informazioni corrette in base al proprio scopo. Un assistente che desse una sola risposta finirebbe per restringere gli scopi dell’essere umano: in breve diventeremmo automi, incapaci di essere creativi.

Per facilitare, invece, il reciproco adattamento soggetto-informazione, educando-ambiente può intervenire il docente in qualità di mentore, di esperto, in grado di guidare i ragazzi nella ricerca e nella selezione. Infatti, affermo sempre che non si potrebbe trovare alcunché senza aver già trovato qualcosa: le informazioni nel museo, su internet, in biblioteca resterebbero mute se non sapessimo già cosa cercare e soprattutto come leggerle. Per questi motivi il web non andrebbe mai inteso come un maestro. Non abbiate paura colleghi, internet non ci sostituirà! Esso resta un ambiente alla pari degli altri, in aggiunta agli altri. Il web non risponde a domande, siamo noi che lo facciamo osservando, confrontando, interpretando come significative le informazioni che reperiamo tra i siti.

Perché dovremmo avere bisogno di una chatbot al posto dei browser?

Anzi, come afferma il cantautore Marcello Stefanelli il browser ci ha insegnato a sintetizzare quello che avremmo voluto trovare attraverso le chiavi di ricerca, le parole essenziali. In breve, ci ha imposto di puntualizzare, e quindi di fissare e non disperdere, pensieri facilmente disattenti. La selezione di una chiave di ricerca è un valido supporto alla cognizione e all’apprendimento in sé. È una mappatura delle idee, dei ragionamenti: è ars dialectica. Platone sosteneva che la filosofia in quanto dialektike era quella capacità di ricordare i giusti collegamenti tra idee. Pertanto, un giudizio sarebbe stato vero se e solo se avesse rispecchiato i nessi tra soggetti e predicati, tra i concetti nell’Iperuranio.

La conoscenza ha bisogno di esplorare le fonti, di confrontarle. Per farsi una propria idea, è necessario scegliere quella che ci sembra appropriata sulla base di varie alternative. Con una chatbot la scelta verrebbe meno, delegata all’assistente virtuale. Mi domando, allora, perché dovremmo avere bisogno di Alexa al posto dei browser. Per rispondere in modo conciso? Per accorciare i nostri tempi di ricerca? Per deresponsabilizzarci?

Il nonno e i vantaggi del robot

Per certe circostanze un assistente vocale è davvero utile. Se mio nonno avesse bisogno di trovare un’informazione o se dovesse gestire un problema con la parte “smart” della sua nuova televisione e io non fossi nelle vicinanze avrebbe una sola alternativa, starsene. Ecco perché i robot sociali, con i loro assistenti vocali incorporati, risultano estremamente utili per gli anziani.

A mio nonno non interesserebbe fare un confronto tra le fonti, gli basterebbe che un assistente fosse in grado di dirgli in modo semplice se domani pioverà per andare nell’orto e che fosse in grado di interfacciarsi alle cose che a noi semplificano la vita, ma che a lui la complicano. Non so, mi immagino un anziano che accendendo la televisione si trovasse su una schermata tra applicazioni come Youtube, Netflix, Amazon. Facilmente non saprebbe come raggiungere i canali consueti. Magari se ci fosse un robot a cui chiedere di inserire un canale prescelto, senza schiacciare alcun pulsante, come se effettivamente fosse sempre pronto ad ascoltare e ad accogliere le richieste dell’anziano, risolverebbe molti problemi.

Mio nonno ha 90 anni e non vuole sentirsi di peso. Allo stesso modo non ha piacere di percepirsi di troppo, alieno, in un mondo per lui muto. In effetti gli ambienti sono informativi solo per coloro che sanno come usare le cose, per coloro che, alfabetizzati ad esse, sanno nominarle e quindi manipolarle. Per tutti gli altri, per quelli che appartengono a un linguaggio e a una cultura diversi, il mondo digitale apparirebbe come un’illusione ottica, con figure-sfondi diversi e irriducibili. Non è che non esista, quel mondo, attenzione! Quell’ambiente sarebbe solo silenzioso, mettendo al contempo a tacere lo “straniero” che vi si approcciasse. In questo caso, inoltre, il problema del solipsismo si porrebbe anche fuori dal contesto della filosofia, entrando direttamente nel mondo della vita.

Per le vecchie generazioni, non educate al digitale, il web è vuoto, non informativo. Un paradosso dal nostro punto di vista. Ma quindi l’ergonomia cognitiva da dove incomincia? In realtà da entrambi i poli: il mondo digitale si è adattato alle nostre strutture che si sono adattate alle strutture digitali. Un circolo vizioso non sbrogliabile: la nostra mano non ha creato il mondo, che, viceversa, non è stato creato dalla nostra mano. Tutto è nato da subito artificiale, reciprocamente modificato.

I limiti che un assistente artificiale non dovrebbe oltrepassare

È evidente che mio nonno troverebbe vantaggi da un robot interpellabile senza tasti, capace di reagire sul piano del linguaggio naturale. Tuttavia, anche qui potrebbero configurarsi problemi non banali. Primo tra tutti non ogni individuo desidera che il robot assistenziale assolvesse a ogni funzione. Ecco perché sarebbe bene poter personalizzare ad hoc i limiti che un assistente artificiale non dovrebbe oltrepassare. Teniamo conto che il robot sociale non è una semplice cosa agli occhi dei soggetti umani: esso è capace di varcare la privacy, potendo mettere in difficoltà le persone con cui interagisce. Ecco, dunque, perché sarebbe bene approcciare alla robotica in senso fenomenologico, vivo, superando l’approccio algoritmico e la pretesa universale.

Ogni volta la tecnologia si inserisce in strutture narrative umane. Come ogni testo, basta nulla per interpolare e modificare l’intero racconto identitario, sortendo effetti nefasti nel benessere bio-psico-sociale del soggetto da assistere. Un essere umano intuisce i tabù degli altri, le difese inconsce che mettiamo in atto quando sentiamo minacciata la nostra zona privata, il robot non può comprendere queste sottigliezze. Sarebbe importante, allora, tarare ogni volta la tecnologia sulla persona, ma purtroppo questa resta un’utopia. Non ci resta che accontentarci, stabilendo pacchetti di funzionalità scalabili (ad esempio assistenza nelle medicine, ma non la sorveglianza emotiva, oppure né uno né l’altro ma solo aiuto per gestire chiamate e canali tv), con il rischio sempre presente di mancare le regole implicite e annichilire l’individuo.

Il problema del linguaggio

C’è da considerare il problema del linguaggio: mio nonno parla italiano, com’è ovvio, tuttavia lui, come ogni generazione passata, vive la lingua italiana e il dialetto sullo stesso piano. Siamo liguri e spesso i genovesismi fanno breccia nella frase. Ecco perché la chatbot dovrebbe considerare l’idioletto, l’individuo e le sue specificità, anche per comprendere e tradurre in pratica le richieste. Anche qui di nuovo è effettivamente problematico tenere conto di ogni linguaggio, di ogni minoranza, finanche dell’individuo nell’addestramento della chatbot. Tale problema non riguarda solo mio nonno, ma i sistemi di NLP in senso lato e le loro applicazioni su vasta scala.

Il solito problema della discriminazione

Può essere pericoloso anche il fatto che tali tecnologie, capaci di catturare lo stile comunicativo degli individui e di imitarlo perfettamente, vengano lasciate a libera disposizione del pubblico. Sarebbe facile che venissero declinate per fini non etici, tra cui manipolare le informazioni e ledere l’altrui reputazione. Tra l’altro, come anticipato sopra, andrebbero comprese a fondo non solo le regole semantiche di ogni comunità, ma anche quelle pragmatiche, perché questi sistemi non finissero per escludere minoranze linguistiche, generazioni, categorie poco rappresentate nel settore tecnologico. In effetti una comunicazione giudicata accettabile da certuni può facilmente risultare per altri disturbante, e questo dipende non certo dalla sintassi o dalla semantica, ma da regole implicite legate alla sfera pragmatica. Pertanto non so come si potrebbe addestrare una rete neurale al non-detto, alle implicature conversazionali, a una sfera che appartiene alla capacità empatica, al corpo, più che ai dati.

L’intelligenza artificiale, del resto, ha la cattiva abitudine di provare a rispondere anche quando non sa, anche quando un sistema esperto darebbe errore. Insomma, il suo voler simulare l’essere umano, il suo fare abduzioni, generalizzazioni, approssimare verità, correlazioni, è ciò che la porta a ripetere bias ossessivamente; è ciò che la trasforma in una “stolta artificiale”. La saggezza, l’intelligenza resta l’umiltà di non sapere, o, comunque, di affermare solo quando si può rendere ragione con fonti, prove, e soprattutto con la volontà di disporsi sempre all’ascolto, al controllo degli effetti, anche quelli meno visibili come le difese legate ai tabù soggettivi.

Conclusioni

Perché, dunque, si propone di sostituire la modalità ipertestuale dei browser con un conversatore che finge di comprendere il linguaggio naturale? Il maestro come prima caratteristica deve sapersi calare nei panni dell’educando, comprendendo il suo vissuto. Solo a partire da questa base empatica, da questa compartecipazione affettiva (forse è questo il senso della “scuola affettuosa” richiesta dal Ministro Bianchi?) si può sapere che cosa rispondergli.

Insomma, non aveva tutti i torti Gentile quando affermava che nell’educazione si realizzava un’unità maestro-alunno, una sintesi. La chatbot, al contrario, finge comprensione. La rete neurale elabora solo dati di cui non ne comprende il senso, restituisce la risposta corretta solo per ragioni statistiche. Per fortuna però noi trascendiamo la statistica: nel possibile scacco al determinismo biologico, sociale, situazionale si collocano gli sporangi di libertà dell’esistenza. Ecco perché non ha senso utilizzare una finzione educativa per rispondere ai nostri bisogni conoscitivi e di adattamento.